最近deepseek很火,我也来蹭一波热度,本次是使用自己的迷你电脑联想(Lenovo)来酷MINI PRO来跑的,机器是很迷你,外观如下图

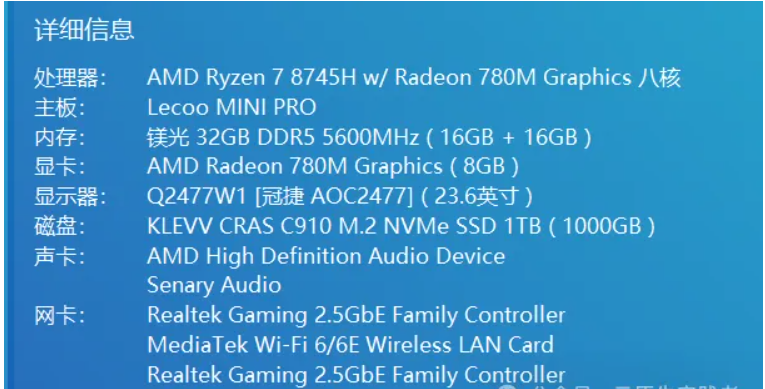

锐龙7 8745H 对比锐龙7 8845H 主频低一点且没有NPU但是价格降了,NPU暂时也用不上,总体性能还不错,性价比也很高,叠加国补当时购买价格2446, 还送了一套联想小新K1轻音键鼠套装,配置如图(BIOS中我给核显分配了8g内存)

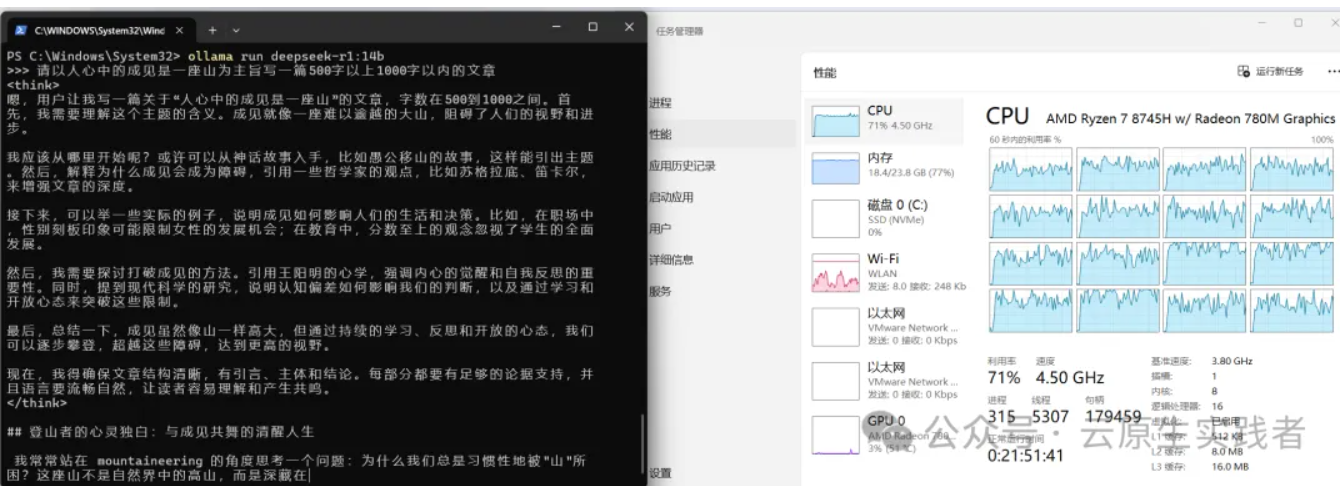

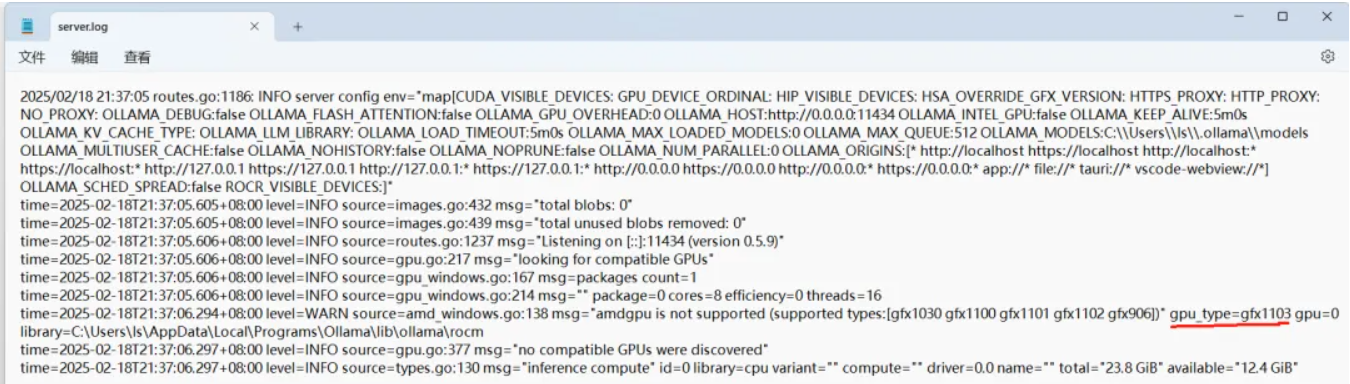

目前用这个机器运行ollama ,如下图发现还是使用cpu和内存跑的而不是使用GPU,虽然速度勉强能行,但是总感觉有遗憾。(最后有GPU运行的视频)

Ollama 通过 AMD ROCm 库提供支持,需满足以下条件:

- Linux 系统:支持 Radeon RX 系列(如 7900 XTX、6800 XT)、Radeon PRO 系列(如 W7900、V620)及 Instinct 加速卡(如 MI300X)。

- Windows 系统(ROCm v6.1+):支持部分 Radeon RX 和 PRO 系列显卡(如 7900 XTX、W6800)。

- 特殊覆盖设置:若显卡未被官方支持(如 RX 5400),可通过环境变量

HSA_OVERRIDE_GFX_VERSION强制匹配相近的 LLVM 目标(如gfx1030)。

我们可以查看 amd 显卡是否支持 ROCm

访问:rocm.docs.amd.com,查看是否有你的显卡型号,如果有,再看列表后面的 HIP SDK 是否为打勾,两者满足时直接下载并安装 AMD 官方版本的 ROCm 和 Ollama 的官方版本就能使用。

对于官方支持 HIP SDK 的显卡,只需要下载并安装 AMD 官方版本的 ROCm 和 Ollama 的官方版本就能直接使用。很显然这里我这台机器的AMD Radeon 780M 并不在官方支持内,这时候我们需要安装ollama-for-amd 来获取对AMD Radeon 780M的支持

安装ollama-for-amd

如果之前安装过ollama官方版本,请先卸载,建议也将GPU驱动升级到最新版本,不然可能会遇到兼容性问题

访问https://github.com/likelovewant/ollama-for-amd/releases 下载OllamaSetup.exe和ollama-windows-amd64.7z

1、运行OllamaSetup.exe安装,下一步下一步即可

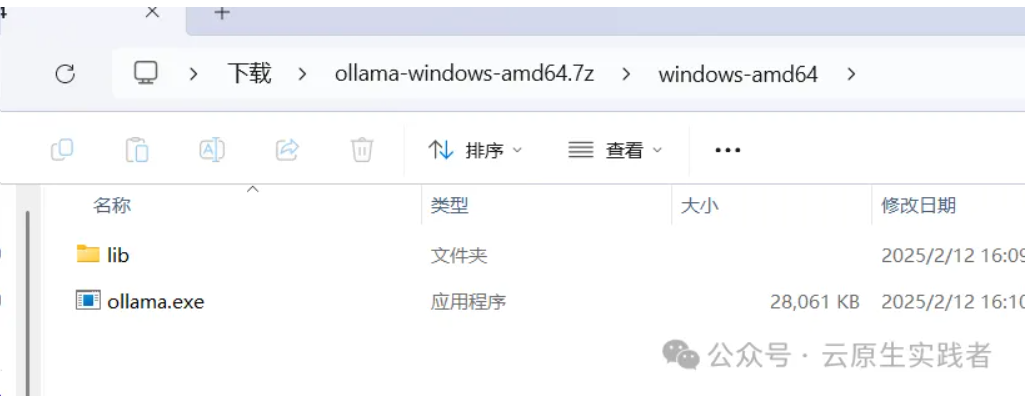

2、解压ollama-windows-amd64.7z,文件内容如下, 用ollama.exe和lib目录替换你电脑中的C:\Users\[你的用户名]\AppData\Local\Programs\Ollama下的lib目录和ollama.exe

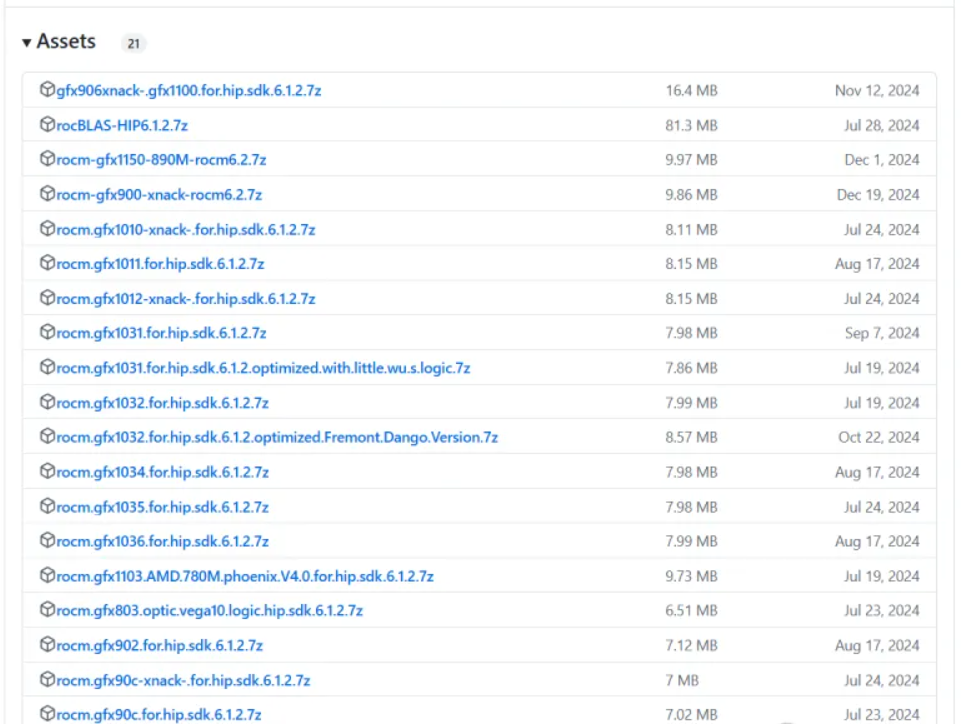

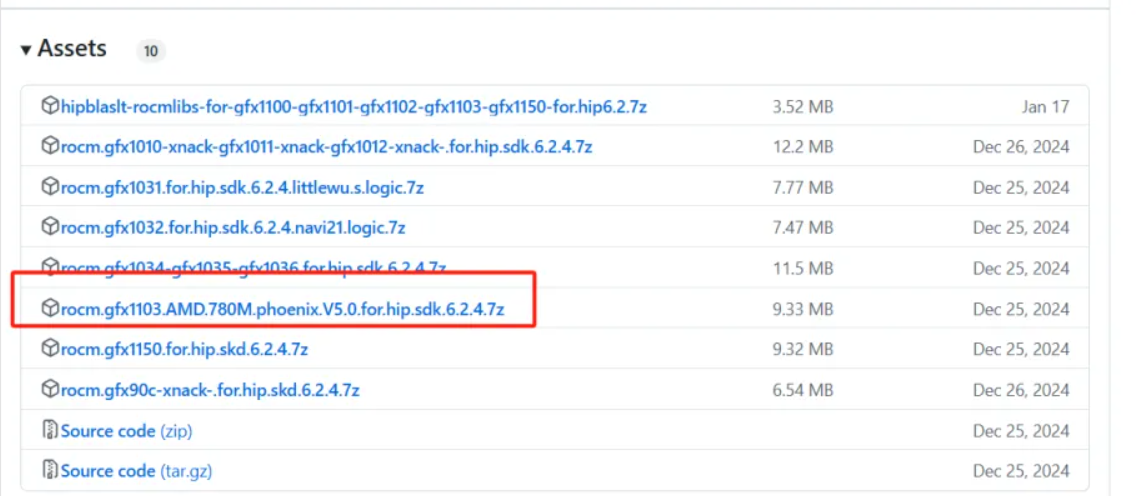

3、访问https://github.com/likelovewant/ROCmLibs-for-gfx1103-AMD780M-APU/releases下载和你显卡对应的ROCmLibs文件

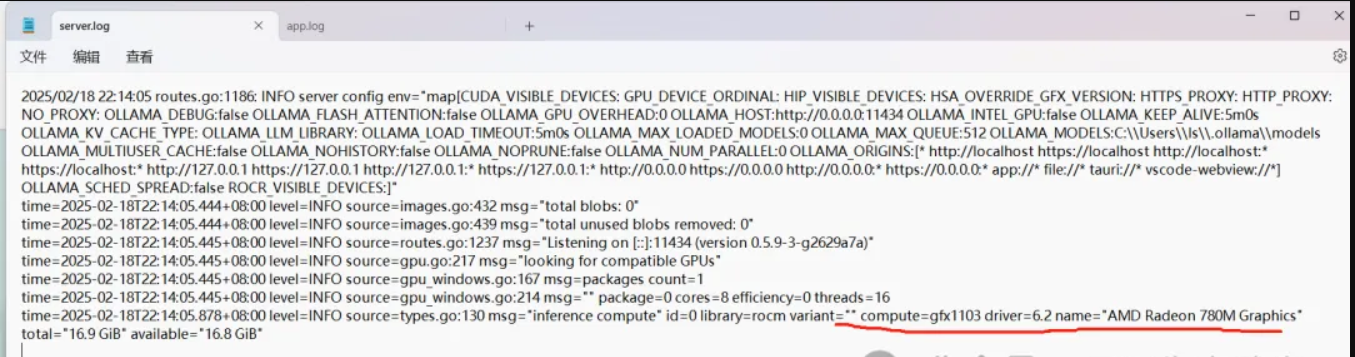

这里有个gfxxx的型号,如果不知道,可以百度一下或者先运行一下ollama在日志中查看 ,进入C:\Users\[你的用户名]\AppData\Local\Ollama

打开其中的server.log ,在日志中搜gpu_typ ,这里我的显卡对应的型号比较明显是gfx1103

这里我选择下载最新的v0.6.2.4,建议下载这个,我一开始下载v0.6.1.2 后面运行deepseek遇到了兼容性报错,还是再提醒一下显卡驱动也要更新到最新

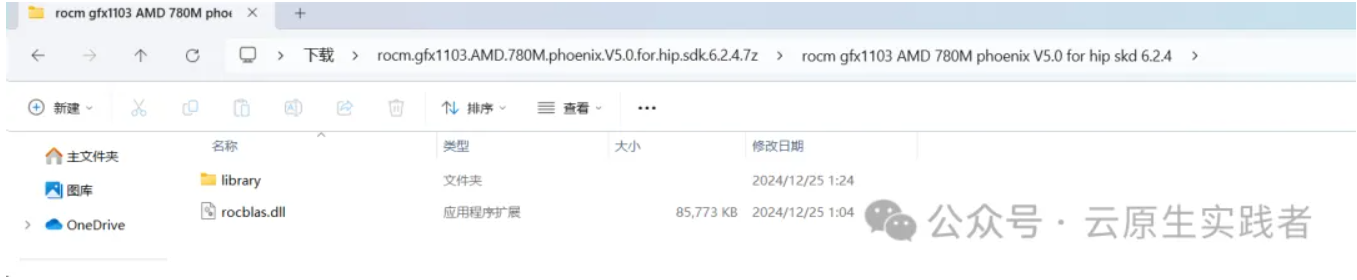

下载完成后解压,文件夹内容如下

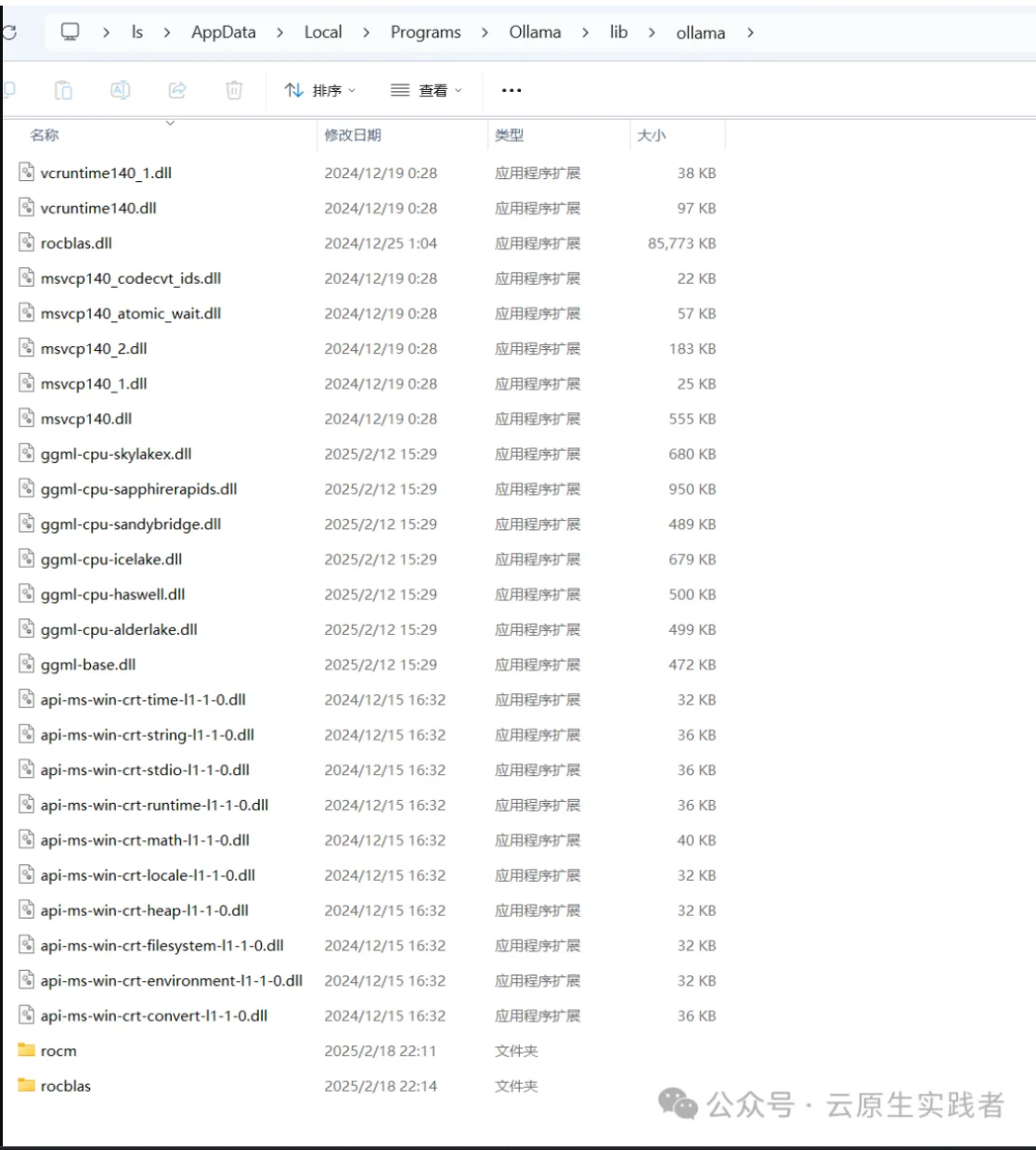

将其中的rocblas.dll文件复制到C:\Users\[你的用户名]\AppData\Local\Programs\Ollama\lib\ollama下

并在C:\Users\[你的用户名]\AppData\Local\Programs\Ollama\lib\ollama下创建rocblas 目录,将 library目录复制到C:\Users\[你的用户名]\AppData\Local\Programs\Ollama\lib\ollama\rocblas 目录里

4、验证一下是否使用的gpu

再次启动ollama并查看server.log,如果出现如下说明成功使用了gpu

还可以终端里运行一下 ollama run deepseek-r1:7b然后退出执行以下ollama ps

PROCESSOR 列会显示模型加载的内存位置:

- • 100% GPU 表示模型完全加载到 GPU 显存

- • 100% CPU 表示模型完全加载到系统内存

- • 48%/52% CPU/GPU 表示模型同时加载到 GPU 显存和系统内存

测速

我们运行一下deepseek-r1测试一下速度

这个是跑的deepseek-r1:7b

这个是跑的deepseek-r1:14b

比起拿cpu运行,GPU运行可以最大限度地压榨GPU的性能,并且速度也更快,目前测试下来deepseek-r1:7b,deepseek-r1:8b,deepseek-r1:14b都可以运行,deepseek-r1:32b就无法运行了,BIOS核显显存调整到16gb也没法运行,应该是需要更大的显存,但是这个机器内存只有32给,BIOS中最高只能分配给核显16g。

后续就可以使用一些客户端工具使用ollama的api接口进行对话了,这个后续有空再写。